-

글로벌 AI 규제 선도를 노리는 영국...AI Assurance 시장 현황

- 트렌드

- 영국

- 런던무역관 이지우

- 2025-12-26

- 출처 : KOTRA

-

영국 AI 안전성·신뢰성 검증(Assurance) 시장, 2035년까지 최대 18배 성장 전망

한국 기업의 영국 AI 검증·거버넌스 분야 참여 기회 확대 전망

최근 영국 내 산업 전반에서 AI 도입이 빠르게 확대되면서, 영국 정부는 AI 모델의 신뢰성과 잠재적 위험 요인을 검증하는 AI 안전성·신뢰성 검증(Assurance) 생태계를 적극 확장하고 있다. 영국 과학혁신기술부(DSIT, Department for Science, Innovation and Technology)에서 2025년 9월에 발표한 보고서에 따르면, 현재 영국에는 5800개 이상의 AI 기업이 활동하고 있다. 또한 영국 기술 산업 생태계를 분석 및 지원하는 대표 기관인 Tech Nation은, 2014년 Tech City UK에서 출범했으며, 스타트업 지원 프로그램과 기술 산업 분석을 수행해 왔다. 2023년 정부 보조금 종료로 운영이 중단됐으나, 이후 Founders Forum Group 산하에서 재출범해 주요 기능을 이어가고 있다. Tech Nation은 영국 AI 산업 규모가 2025년 1분기 기준 약 2300억 달러에 달한다고 평가하고 있다.

영국 과학혁신기술부(DSIT)와 Frontier Economics 분석에 따르면, 2024년 기준 AI Assurance 생태계 규모는 약 10억1000만 파운드(한화 약 1조9600억 원)이며, 관련 기업은 524개다. 이 중 84개 기업이 전문 검증 기능을 보유하고 있다. 향후 시장 전망은 영국 정부의 AI 규제 체계가 얼마나 구체화되는지, 그리고 주요 산업에서 AI 검증 수요가 어느 수준으로 확대되는지에 따라 달라진다. 이에 따라 2035년 시장 규모는 최소 65억3000만 파운드(한화 약 12조7437억)에서 최대 188억 파운드(한화 약 36조6893억) 규모(현재 시장 규모 대비 약 18배)까지 성장할 수 있는 것으로 분석된다.

이러한 산업 발전 과정에서 금융, 의료, 공공부문과 같이 데이터 처리 단계에서 사이버보안 위협, 시스템 장애, 개인정보 유출 등 기존의 운영 리스크에 취약한 산업에서는 최근 AI 학습 데이터 편향, 데이터 품질 저하, 모델 오작동, 보안 취약성 등 AI 특유의 위험 요인이 새롭게 주목받고 있다. 이에 따라 정부의 정책적 대응 속도 역시 한층 빨라지고 있다. 영국 과학혁신기술부(DSIT)는 2023년 신설 이후 연속적으로 주요 AI 정책 문서를 발표하며 AI 규제 원칙을 마련하고, AI 안전성·신뢰성 검증 개념을 체계화하며 AI Assurance를 새로운 성장 산업으로 공식화했다.

<영국 정부 AI 규제 및 Assurance 관련 주요 정책>

발표 연도

정책명

주요 내용 요약

2023

AI Regulation: a pro-innovation approach

(혁신 촉진형 AI 규제 방안)

- 분산형 규제 모델(산업별 자율 규제) 제시

- 원칙 기반 감독 체계 도입: 정부는 기본 원칙 제시, 세부 규제는 각 분야 감독기관이 담당

2024

Introduction to AI Assurance

(AI 안전성·신뢰성 검증 개론)

- AI 안전성·신뢰성(Assurance) 개념·역할·범위 구체화

- 위험 검증 절차 및 활용 사례 제시

- 평가·검증·검사 프레임워크 소개

- 생태계는 △AI 개발 기업 △AI 도입·운영 기업 △독립 검증기관 △산업별 규제기관 △표준기관 등으로 구성

2025

Trusted Third-party AI Assurance Roadmap

(신뢰할 수 있는 제3자 AI 안전성·신뢰성 검증기관 육성 로드맵)

- 제3자 검증 시장 조성 전략 명시

- 인증 체계 구축 및 평가 기준 정비

- AI 안전성·신뢰성(Assurance) 산업을 신성장 산업군으로 규정

- 제3자 검증기관은 기술적 분석 역량뿐 아니라 규제 및 정책 이해, 모델 문서화, 산업 전문성 등 복합 능력이 요구됨

[자료: 영국 과학혁신기술부(DSIT) 발표 자료 종합]

AI Assurance란?

영국 과학혁신기술부(DSIT)는 2024년 AI Assurance를 “AI 시스템의 신뢰성을 측정하고(measure), 평가하며(evaluate), 그 결과를 명확하게 전달하는(communicate) 모든 절차”로 정의했다. 이는 개별검사 도구를 의미하는 것이 아니라, AI 안전성과 신뢰성을 확보하기 위해 수행되는 일련의 활동 전체를 포괄하는 개념이다. 한편, 2025년 발표된 로드맵은 AI Assurance를 책임 있는 AI 개발 및 운영, 규제 준수, 사회적 신뢰 구축, 경제 성장 촉진을 위한 핵심 기반으로 더 확대해 설명하고 있다.

AI Assurance 절차는 ▲측정(성능·편향·보안성 데이터 수집) ▲평가(위험 대비 기준·규제 원칙 충족 여부 판단) ▲소통(결과 문서화 및 투명한 제공) 세 단계로 구성된다. 이러한 과정을 거쳐 AI Assurance는 단순 성능 진단을 넘어 내부 통제, 위험관리, 문서화, 설명 가능성, 법·윤리 기준까지 통합하는 종합적 신뢰성 관리 체계로 작동한다.

영국의 분산형 AI 규제 체계

영국은 EU AI Act*에서 규정하는 것처럼 단일 AI 감독기관을 두지 않고 ICO(정보보호 규제 기관), FCA(금융감독기관), CMA(경쟁감독기관) 등 기존 규제기관이 각자의 법적 권한 내에서 AI를 감독하는 분산형 규제구조를 채택하고 있다. 이 기관들을 조율하는 역할은 과학혁신기술부(DSIT)가 맡고 있다. AI 규제 원칙 제시, 부처 간 협의체 운영, 정책 가이드라인 발간, 공통 위험 평가 체계 마련 등 정책과 조정 중심의 역할을 수행하지만, 직접적인 제재 권한은 없다.

* EU AI Act(인공지능법): EU가 세계 최초로 도입한 포괄적 인공지능 규제법으로, AI 시스템을 위험도(금지·고위험·중위험·저위험의 4단계) 기준으로 분류하고, 고위험 AI에 대해 데이터 품질, 투명성, 안전성 검증 등 엄격한 규제 요건을 부과하는 법률

<영국 주요 AI 관련 규제기관 및 역할>

기관

설명

ICO

(Information Commissioner’s Office)

영국의 개인정보 보호와 데이터 권리 감독을 담당하는 국가 정보보호 규제기관

FCA

(Financial Conduct Authority)

금융시장 안정성과 금융서비스 기업의 규제 및 감독을 담당하는 영국 금융행위감독청

CMA

(Competition and Markets Authority)

시장 경쟁 보호, 기업 간 담합·불공정 행위 감시, 소비자 보호를 담당하는 영국 경쟁·시장감독청

[자료: ICO, FCA, CMA 등 각 기관 홈페이지 및 KOTRA 런던무역관 정리]

분산형 규제를 위해 영국 정부는 다음의 5대 규제 원칙을 제시하고 있으며, 이는 실제 AI Assurance 평가 기준으로 바로 연결된다.

<5대 규제 원칙>

구분

내용

1

안전성, 보안성 및 견고성(Safety, Security, and Robustness)

* Robustness: 비정상 입력에도 모델이 안정적으로 작동하는 능력

2

적절한 투명성 및 설명 가능성(Appropriate Transparency and Explainability)

3

공정성(Fairness)

4

책임성 및 거버넌스(Accountability and Governance)

5

이의제기 및 구제 절차(Contestability and Redress)

[자료: 영국 과학혁신기술부(DSIT): AI regulation: a pro-innovation approach (2023.3.29.), KOTRA 런던무역관 정리]

이는 기술 혁신을 저해하지 않는 범위에서 신뢰성을 확보하려는 영국식 규제 접근 방식이다.

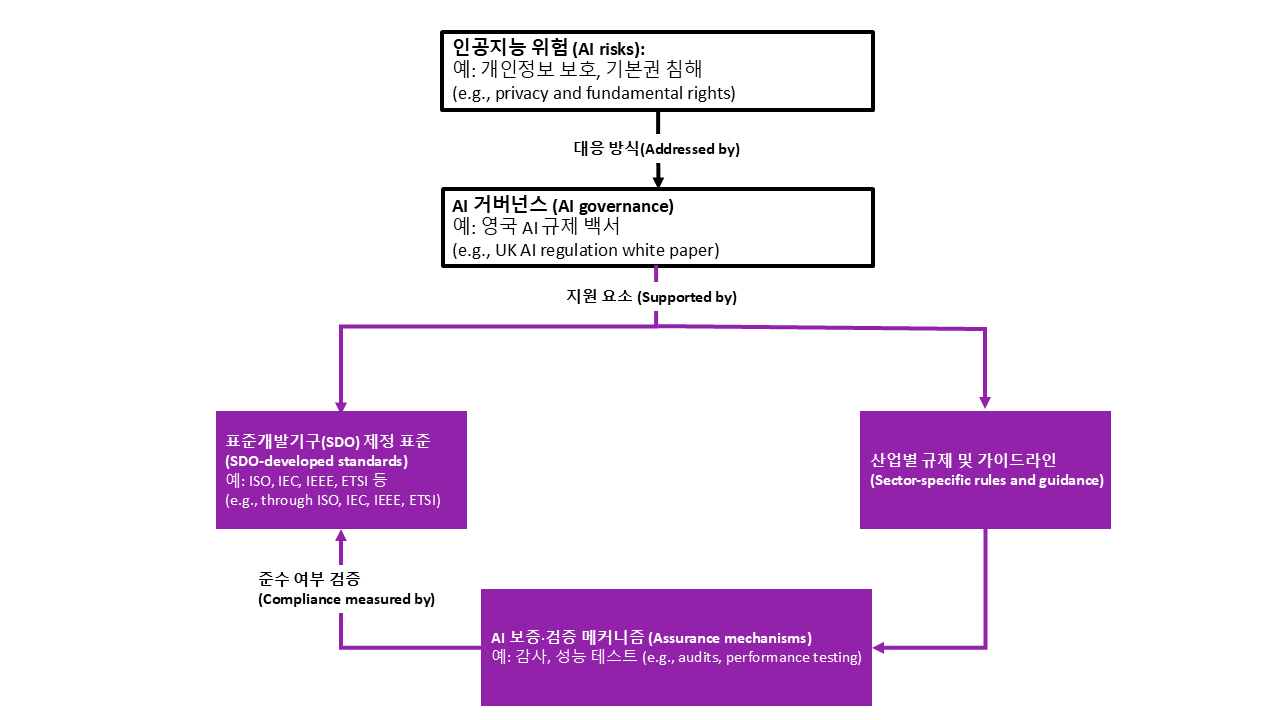

<영국 AI Assurance 규제 체계>

[자료: 영국 과학혁신기술부(DSIT): Introduction to AI Assurance (2024.2.12.), KOTRA 런던무역관 가공]

위 도식은 영국의 ‘분산형 AI 규제 구조’가 실제로 어떻게 작동하는지를 보여준다. 우선 AI로 발생할 수 있는 위험(AI Risks)에 대해서는 우선 정부가 AI 규제 백서에서 제시한 거버넌스 체계에 따라 대응 방향을 설정한다. 이어, 이러한 거버넌스의 틀 안에서 국제 표준 기구가 제정한 기술 표준과 각 분야 규제기관이 제시하는 구체적인 가이드라인을 마련한다. 마지막으로, 기업이 기술 표준과 가이드라인을 제대로 준수하고 있는지는 감사(Audit)나 성능 테스트 등 AI 안전성·신뢰성 검증(Assurance) 절차를 통해 실제로 확인한다.

영국은 EU와 달리 AI 사전 인증 제도를 운영하지 않기 때문에, 문제 발생 시 개인정보보호법(General Data Protection Regulation, GDPR), 금융법, 경쟁법 등 기존 법령에 기반한 사후 규제가 적용된다. 이에 따라 기업은 규제 요구가 명확하지 않은 상황에서도 국제표준과 정부 가이드라인을 기준으로 데이터 감사, 편향 검증, 모니터링, 문서화 등 AI Assurance 역량을 선제적으로 구축할 필요가 있다.

<EU AI Act(2024)의 사전인증 제도>

EU는 AI를 위험성에 따라 분류하고, 특히 고위험 AI 시스템에 대해 제품 출시 전 반드시 다음의 절차를 거쳐 사전인증(사전 적합성 평가)을 받도록 의무화하고 있다.

1. 위험 분류(Risk Classification) : 해당 AI 시스템이 고위험으로 분류되는지 여부 판단

2. 기술요건 충족(Technical Requirements): 고위험 AI로 분류되는 경우, 다음 항목 충족 필요

- ▲데이터 품질 관리 여부 ▲편향 방지 ▲설명 가능성 및 투명성 ▲로그 기록 의무 ▲사이버 보안 조치 ▲인간 감독(Human Oversight)

3. 적합성 평가(Conformity Assessment): 제조사 또는 개발사가 자체적으로 평가하거나, 분야에 따라 공인 인증기관 심사 필요

4. CE 마크 부여(CE Marking): 기준 충족이 인정되는 경우, CE 마크를 부여받아 EU 시장 내 합법적 판매·운영 가능

5. 사후 모니터링 및 보고 의무(Post-market Monitoring): 서비스 제공 이후에도 위험·오류 발생 여부를 지속 모니터링하고, 문제 발생 시 규제 기관에 보고

주요 기업 동향

AI Assurance 시장 구조는 편향 검사, 모델 모니터링, 견고성 시험 등을 직접 수행하는 ‘기술 중심 기업’과 거버넌스 및 규제 대응, 모델 검증 서비스를 제공하는 ‘대형 컨설팅사’의 두 축으로 구성된다. 한편, 영국표준원(BSI)은 ISO/IEC 42001(관리 체계)*과 ISO/IEC 42006(검증기관 기준)**을 도입해 향후 공식 인증기관과 비인증 제공자 간 시장 구분이 보다 명확해질 전망이다.

* ISO/IEC 42001(관리 체계): AI 관리 체계에 대한 국제 표준으로, AI 시스템 운영 전반에 적용되는 위험 기반 관리 체계 요구사항을 규정한다. 조직은 이 표준을 통해 AI 거버넌스 구조, 책임 배분, 데이터·모델 관리, 모니터링 및 개선 절차를 체계화해야 하며, 이를 통해 투명성과 책임성을 갖춘 AI 운영을 구현하도록 한다.

** ISO/IEC 42006(검증기관 기준): ISO/IEC 42001 기반 AI 관리 체계를 심사·인증하는 기관이 충족해야 할 역량과 절차를 규정한 표준이다. 심사기관의 독립성, 전문성, 인력 자격, 감사 프로세스의 일관성 및 품질관리 요건을 명시해, AI 인증 서비스의 객관성과 신뢰성을 확보하는 것을 목표로 한다.

<영국 내 주요 AI Assurance 운영 기업>

구분

기업명

특징

최초 설립

전문 AI Assurance 기업

Holistic AI

- UCL(University College London) 연구진이 설립한 AI 리스크 관리 플랫폼 제공 기업

- AI 모델의 편향(Bias), 공정성(Fairness), 견고성(Robustness, 비정상 입력에도 모델이 안정적으로 작동하는 능력), 드리프트(Drift, 데이터 환경이 변하면서 모델 성능이 떨어지는 현상), 거버넌스(Governance, 내부 관리·통제 체계) 등 다양한 요소 모니터링 가능

- 다수의 정부·금융기관과의 프로젝트 경험으로, 정책·규제 요구에 기반한 모델 검증(Model Validation) 역량 확보

런던, 영국

(2020)

- AI 모델 개발, 데이터 분석, AI 리스크 관리 등을 제공하는 영국의 전문 AI 솔루션 기업

- 영국 중앙정부, Cabinet Office(내각부), NHS(국민보건서비스), 국방부 등 공공기관의 대규모 AI 프로젝트 수행

- 정부 산하 AI Safety Institute(인공지능 안전 연구소)의 실험·검증 프로그램 참여로 고위험 모델 시험·평가 경험 보유

런던, 영국

(2014)

- 옥스퍼드대학 내 연구 성과를 기반으로 설립된 Responsible AI(책임 중심 AI) 전문기업

- 보험, 인프라, 국방 등 고위험 환경(High-stakes Environment) 분야에서의 검증(Validation), 리스크 관리(Risk Management), 모니터링(Operation Monitoring) 기능 제공

옥스퍼드, 영국 (2016)

대형

컨설팅

기업

- 영국계 글로벌 컨설팅 기업으로, 금융·규제 분야 기반의 리스크 중심 AI 검증 역량 보유

- 5단계 AI Assurance 프레임워크 보유

1. Governance(거버넌스): 내부 관리체계 평가

2. Data(데이터): 데이터 품질·적정성 점검

3. Modelling(모델링): 알고리즘 구조·성능 검증

4. Pre-deployment(사전 운영 점검)

5. Monitoring(운영 모니터링)

- 규제 준수(Compliance) 및 모델 리스크 관리(MRM: Model Risk Management) 컨설팅 제공

런던, 영국

(1845)

- 영국에서 출발한 글로벌 컨설팅 기업으로, 정책·규제기관 협업 경험을 바탕으로 한 AI 거버넌스 내재화 특화

- FCA(Financial Conduct Authority, 금융행위감독청)가 운영하는 AI Public-Private Forum(PPF: 공공-민간 협의체) 공동 참여 기관으로, 영국의 AI 규제 논의에 다수 참여

- Responsible AI·AI Governance 프레임워크를 내재화한 고유 플랫폼(PwC AI Engine) 보유

런던, 영국

(1998)

-글로벌 본사가 런던에 있는 컨설팅 기업으로, 기술·보안 중심의 AI 리스크 평가 강점

- TPRM(Third-Party Risk Management, 제3자 리스크 관리), Enterprise Risk(전사적 리스크 관리), Cybersecurity(사이버 보안) 등 기존 거버넌스 체계 속에 AI Governance(인공지능 관리체계)를 통합하는 로드맵 제공

- EY.ai Trust 플랫폼을 통해 고위험 모델 평가, 운영 모니터링, 검증 환경 제공

- EU AI Act, 영국 AI 5대 규제 원칙, OECD AI 원칙 등 국제 규제 기준을 충족하는 관리 체계 설계 역량 보유

런던, 영국

(1989)

[자료: Holistic AI, Faculty AI 등 각 기업 홈페이지 및 KOTRA 런던무역관 정리]

시장 과제

영국의 AI Assurance 시장은 아직 초기 단계로, 기밀성과 보안 문제로 인한 모델·데이터 접근 제한과 기술, 법률, 윤리를 모두 이해할 수 있는 전문 인력 부족이 주요 성장 제약 요인으로 지적된다. 중소기업의 비용 부담, 검증기관 간 품질 편차 또한 시장 확대를 어렵게 하는 요인으로 꼽힌다. 실제로 대부분의 영국 기업은 내부 AI 위험관리 역량이 부족하며, 특히 전체 기업의 99%를 차지하는 중소기업은 검증 인력, 기술, 비용 측면에서 구조적 제약이 크다. 이에 따라 외부 검증기관이나 SaaS(서비스형 소프트웨어) 기반 자동화 검증 솔루션에 대한 의존도가 높아지고 있으며, 시장 역시 이러한 분야를 중심으로 성장하고 있다.

영국 A 컨설팅사의 AI 및 데이터 담당 시니어 컨설턴트 A 씨는 KOTRA 런던무역관과의 유선 인터뷰에서 “AI Assurance가 아직 프로젝트 발주 단계에는 이르지 않았지만, 최근 기업 내부에서 ‘어떤 검증이 필요한가’, ‘어느 수준까지 준비해야 하는가’에 대한 논의가 빠르게 증가하고 있다"라고 설명했다. 이어서 “정부와 기관의 가이드라인이 지속 업데이트되는 상황에서 기업들은 먼저 구축해야 할 사항을 판단하는 데 어려움을 느끼고 있다. 다만 내부 논의는 꾸준히 확대되고 있으며, 컨설팅사들은 AI Assurance와 Governance 관련 인력을 선제적으로 확충하고 있다”라고 덧붙였다.

시사점

영국 디지털·데이터청(Central Digital and Data Office, CDDO)은 영국 정부 내 디지털 전환과 데이터 거버넌스를 총괄하는 중앙기관으로, 공공부문의 기술과 데이터 활용 기준을 수립하고 부처 간 디지털 정책을 조율하는 역할을 수행한다. CDDO는 이러한 기능의 일환으로 ‘AI Testing and Assurance Framework’를 발표하고 조달 부문에 이 프레임워크의 적용을 확대하고 있다. 이 프레임워크는 설계, 개발, 배포, 운영 단계별로 테스트, 평가, 검증(assurance)을 위한 공통 기준을 제시하며, AI Assurance 보고서를 통해 기준 충족 여부를 확인하도록 설계돼 있다. 아직 보고서 제출이 의무화된 것은 아니지만, 향후 영국 정부가 공공 조달 참여 기업에 이를 요구할 가능성이 제기되고 있다.

영국의 AI Assurance 시장은 제도와 표준이 정착되는 과도기 단계에 있기에 전문성과 신뢰성을 갖춘 기업이 진입한다면, 장기적 경쟁우위를 확보할 가능성이 크다. 자격을 갖추고 시장진입을 꾀하는 기업이라면 우선 ISO/IEC 42001과 42006 등 국제 표준을 기반으로 내부 AI 거버넌스 체계를 구축해 신뢰를 확보하는 노력이 필요하다. 이후 영국 내 제3자 검증기관과 협력해 초기 레퍼런스를 확보하는 방식이 효과적인 시장진입 전략으로 평가된다.

공공 조달 참여가 목표라면 영국 디지털·데이터청(CDDO)과 과학혁신기술부(DSIT)가 제시하는 기준을 충족하는 사전 AI Assurance 보고서를 준비하는 것이 필요하다. 또한 현지 컨설팅사와의 파트너십 체결, 영국 기업 및 기관과의 공동 프로젝트 수행, 영국 기업 대상 SaaS 구독 확대, 그리고 Alan Turing Institute나 AI Safety Institute 등 현지 연구 및 평가 프로그램 참여를 통해 영국 AI 생태계와의 접점을 늘려가는 것이 유리하다.

최근 한-영 양국은 한국 기획재정부가 제안한 선진국형 경제발전경험 공유사업(Knowledge Sharing Program, KSP)을 통해 AI 안전성 및 기술 표준 분야에서의 협력을 합의했다. 이에 따라 양국의 연구진, 정부 관계자, 산업 전문가들은 AI 안전성, 양자 기술, 차세대 반도체 등의 분야에서 협력 의제 발굴을 위한 논의를 진행하고 있다.

또한, 한국 정보통신기술협회(TTA)와 영국 왕실표준협회(BSI)는 KSP사업의 일환으로 AI, 양자, 6G 분야 협력 MOU 체결을 추진 중이다. 이러한 양국 간 표준·검증 협력은 한국 기업이 영국 AI Assurance 생태계에 진입할 수 있는 제도적 기반을 마련하며, 한국 기업의 현지 시장 참여 이력(레퍼런스) 확보에 좋은 기회가 되고 있다.

특히 향후 영국 AI Assurance 생태계에서 공공 조달, 기술 인증, 제3자 검증 시장이 빠르게 확대될 것으로 예상되는 만큼, 영국 AI 시장에 진출하려는 기업이라면 지금 기회를 최대한 활용하려는 노력이 필요하다.

자료: gov.uk, Tech Nation, ICO, European Commission, BSI Group, ISO, CDDO, Holistic AI 등 각 기업 및 기관 웹사이트, KOTRA 런던무역관 종합

<저작권자 : ⓒ KOTRA & KOTRA 해외시장뉴스>

KOTRA의 저작물인 (글로벌 AI 규제 선도를 노리는 영국...AI Assurance 시장 현황)의 경우 ‘공공누리 제4 유형: 출처표시+상업적 이용금지+변경금지’ 조건에 따라 이용할 수 있습니다. 다만, 사진, 이미지의 경우 제3자에게 저작권이 있으므로 사용할 수 없습니다.

-

1

일본 ‘금리 있는 시대’의 시작…메가뱅크는 지금 ‘디지털 고객’ 확보 경쟁

일본 2025-12-26

-

2

자연스러움이 트렌드가 되다... 미국 MZ세대 패션의 변화

미국 2025-12-26

-

3

중국 Z세대를 겨냥한 마케팅 방법, 팟캐스트를 주목하라

중국 2025-12-18

-

4

2025년 스페인 제약산업 정보

스페인 2025-12-26

-

5

첨단 산업의 핵심 원자재 '황린', 베트남 공급망의 기회와 위기

베트남 2025-12-23

-

6

경기장을 넘어 일상으로… 미국 스포츠 마케팅과 지적재산권

미국 2025-12-22

-

1

2025년 영국 의료 산업 정보

영국 2025-08-27

-

2

2025년 영국 원자력 산업 정보

영국 2025-04-07

-

3

2024년 영국 자동차산업 정보

영국 2024-08-02

-

4

2024 영국 금융 산업 동향

영국 2024-07-12

-

5

2021년 영국 농식품 산업 정보

영국 2021-09-30

-

6

2021년 영국 항공우주-방위 산업 정보

영국 2021-09-23